- Inspirations>

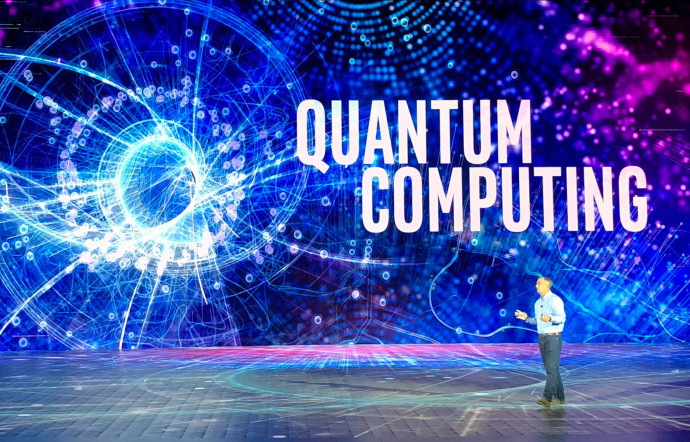

Il y a encore deux ans, l’ordinateur quantique n’était qu’une piste de recherche exploratoire, académique, suivie par quelques scientifiques aussi experts que partagés sur l’avenir de cette technologie. Depuis, les choses ont changé. En janvier dernier, ce concept était même l’une des stars de la messe mondiale de l’innovation technologique, le CES de Las Vegas. Rien de moins.

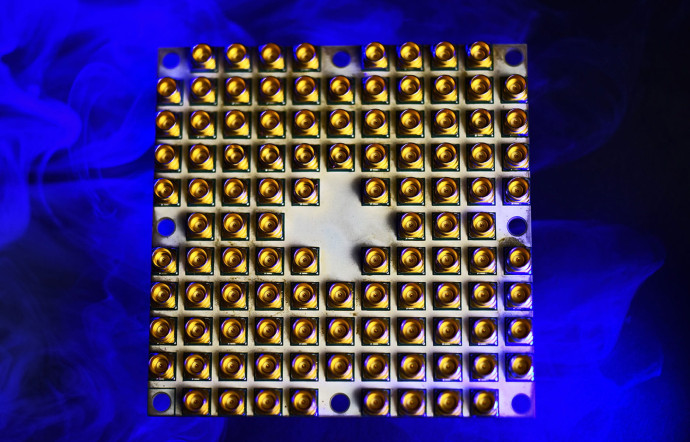

L’ordinateur quantique a eu droit à un show à l’américaine de deux heures, orchestré par Intel, lors du CES de Las Vegas. Aux manettes, le CEO d’Intel lui-même, Brian Krzanich qui, après avoir usé de superlatifs sur la réalité virtuelle, la vidéo volumétrique, ou encore un prototype de puce neuromorphique, a annoncé la fabrication de Tangle Lake, une puce expérimentale à 49 bits quantiques (ou qubits). « Une avancée majeure », a-t-il assuré en brandissant un petit carré blanc, grand comme la main, serti de gros plots dorés. Vue de loin, une sorte de jeu du solitaire.

Pas exactement l’idée qu’on se ferait d’une technologie de pointe. Et pourtant, avec cette plaque – qui, en réalité, a la taille d’une pièce de 1 centime –, Intel prend ce jour-là la tête d’une course effrénée, entamée en mai 2017. A l’époque, IBM annonce avoir créé un prototype de calculateur à 16 et 17 qubits. Dès le mois d’octobre, Intel s’aligne et présente son circuit à 17 qubits, fait d’un métal semi-conducteur reposant sur du silicium. Un mois plus tard, rebelote : IBM renchérit avec un circuit à 50 qubits qui aurait fonctionné pendant quelques microsecondes. Un succès enterré par la puce de 49 qubits d’Intel… elle aussi détrônée, le 5 mars 2018, par le processeur à 72 qubits de Google.

A l’heure où les processeurs classiques atteignent des milliards de milliards de bits, cette compétition de quelques qubits pourrait paraître un peu incongrue. Mais c’est omettre un détail : une puce de 20 qubits a la puissance de calcul du plus performant des supercalculateurs actuels. Des supercalculateurs à l’avenir par ailleurs limité puisque, dès les années 80, des chercheurs de renom, comme Yuri Manin et Richard Feynman, ont estimé qu’aucun ordinateur classique ne pourrait jamais atteindre la puissance de 50 qubits, le seuil théorique de la suprématie quantique. Voilà pourquoi chez IBM, Intel, Google ou Microsoft, les annonces se cristallisent autour de cette frontière. C’est une sorte de mur du son que ces compagnies tentent de passer.

Et l’enjeu est à la mesure des acteurs en lice. Si les processeurs quantiques deviennent réalité, ils rendront d’un coup obsolètes tous les systèmes de sécurité bancaires, téléphoniques ou informatiques. Pourquoi ?

Parce que le recours au bit quantique décuplerait, dans des proportions inimaginables, les puissances de calculs informatiques, permettant de résoudre des problèmes aujourd’hui insolubles et de calculer, rapidement, ce que des ordinateurs classiques mettent des mois, voire des années, à mouliner.

Tout ça grâce aux qubits, mais aussi grâce aux algorithmes, très différents, qui les font fonctionner. Explication : dans un ordinateur classique, tous les calculs se font dans un système binaire, c’est-à-dire avec des bits qui ne peuvent prendre que deux valeurs, 0 ou 1. Or, dans un ordinateur quantique, chaque qubit peut prendre une valeur parmi une infinité de possibilités. Ainsi, là où un ordinateur classique aura besoin de 8 bits pour coder, par exemple, l’une des 256 couleurs d’un écran, un ordinateur quantique n’aura besoin que d’un qubit.

D’un point de vue mathématique, cette caractéristique change la donne et permet des algorithmes très différents de ceux actuellement utilisés. De quoi démultiplier le champ des possibles. Mais, comme souvent, il y a un « mais ». Au-delà des effets d’annonce, ces puces quantiques restent très expérimentales et posent encore de vrais problèmes techniques.

Le revers du qubit

Les qubits sont très fragiles et peuvent facilement perdre l’information stockée… ce qui n’est pas un détail. Par ailleurs, ils reposent sur des propriétés très particulières de la matière, obtenues dans des conditions extrêmes. Ce n’est pas pour rien que la puce à 49 qubits d’Intel s’appelle Tangle Lake, du nom de lacs situés en Alaska. Car, pour fonctionner, la puce doit se trouver à 20 millikelvin, soit – 273 °C ! Pas exactement une température facile à atteindre dans son salon…

En outre, plus la taille de la puce augmente, plus il devient difficile de conserver l’état dit de cohérence quantique nécessaire au maintien des qubits. De fait, le risque d’erreur s’accroît. La complexité de ces verrous techniques est telle que chaque compagnie développe ses propres solutions, que ce soit au niveau des « qu-processeurs » ou du code. Ainsi, si les équipes collaborant avec Intel tentent de créer des codes pouvant détecter et corriger les erreurs des qubits, celles d’IBM cherchent plutôt à connaître le nombre maximal d’opérations qu’un qubit peut effectuer à la suite, sans avoir un trop grand risque d’erreur.

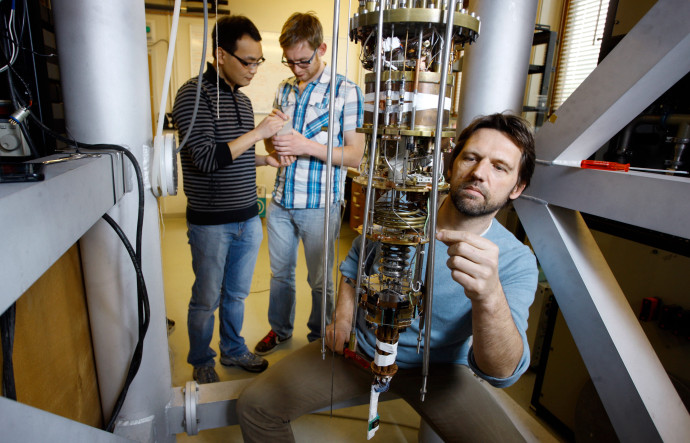

« Reste que la finalité de ces recherches n’est pas seulement la création d’un ordinateur », insiste Boris Chenaud de l’université de Montpellier. Bien d’autres technologies pourraient émerger de ces études, comme des serveurs, des télécommunications ou des microscopes quantiques. En réalité, c’est un nouveau continent de technologies que les géants de l’informatique tentent d’aborder. C’est pourquoi, dès 2015, Intel a établi une collaboration au long court avec un grand centre de recherche néerlandais, le QuTech, à l’université de Delft.

Une décision tout sauf anecdotique : Leo Kouwenhoven, une référence du monde quantique, y a son laboratoire. Mais surtout, le QuTech possède une académie unique au monde, dont l’ambition est de former, non pas des chercheurs, mais des ingénieurs. Des ingénieurs capables de penser le monde en quantique, de coder quantique et de créer les technologies quantiques de demain. « Car si les systèmes de sécurité ou les technologies deviennent obsolètes, il faudra bien en imaginer de nouveaux », commente Boris Chenaud.

Voilà pourquoi Microsoft, Intel ou le gouvernement néerlandais ont investi des centaines de millions d’euros dans ce centre qui a pour mission de créer le code capable d’utiliser le prototype à 49 qubits d’Intel. En parallèle, le QuTech et Intel viennent de lancer un programme sur cinq ans pour aboutir à la création d’un processeur de 1 024 qubits. La course aux technologies quantiques ne fait que commencer…